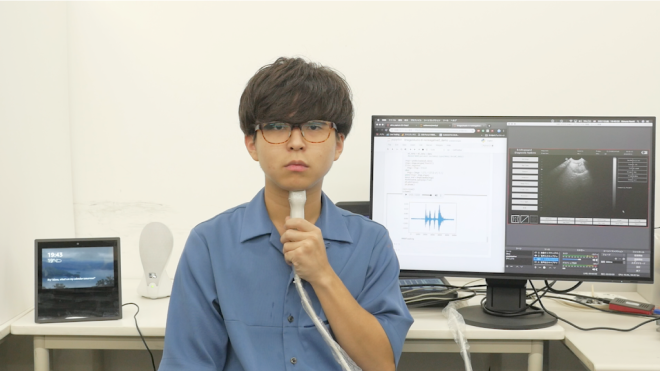

The availability of digital devices operated by voice is rapidly expanding. However, the usage situation of voice interfaces is still restricted. For example, speaking in public places becomes an annoyance to surrounding people, and secret information should not be uttered. Environmental noise may reduce the accuracy of the speech recognition. To address these limitations, SottoVoce detects a user’s unuttered voice. From internal information observed by an ultrasonic imaging sensor attached to the underside of the jaw, our proposed system recognizes the utterance contents without the user actually uttering voice. Our proposed deep neural network model is used to obtain acoustic features from a sequence of ultrasound images. We confirmed that audio signals generated by our system can control existing smart speakers. We also observed that a user can adjust their oral movement to learn and improve accuracy of their voice recognition.

音声によって操作されるデジタル機器の利用可能性は急速に拡大している.しかし,音声インタフェースの使用状況は依然として制限されている.たとえば,公共の場で話すことは周囲の人に迷惑になり,秘密の情報を話すことができない.SottoVoce (ソット・ヴォーチェ、音楽用語で 「ささやくように」)は,超音波エコー映像を用いて,利用者の無発声音声を検出するシステムを提案する.顎の下側に取り付けられた超音波イメージングプローブによって観察される口腔内の情報から,利用者が声帯を振動させずに発話した発声内容を認識する.超音波画像の系列から音響特徴を生成するニューラルネットモデルを提案する.提案モデルにより,合成したオーディオ信号が Amazon Echo など、既存の無改造のスマートスピーカーを制御できることを確認した.これにより,人間とコンピュータが緊密に連携した種々のインタラクションが可能になり,新しいウェアラブルコンピュータが構成可能になる.また,咽頭の障害,声帯機能障害,高齢による発声困難者に対して,声によるコミュニケーションを取り戻すための技術基盤につながるものである.

SottoVoceを使うと、利用者のほうでも口パクを調整してうまく音声になるように歩み寄る傾向があった。これは、ニューラルネットが学習しているだけでなく、ニューラルネットによって外在化された人間の能力を、人間側も学習していることになる。人間とAIとが一体化した新しいインタラクションの方向を示しているともいえる。これを 「ヒューマン・AI・インテグレーション」と呼び、今回のような無発声発話だけではなく、楽器の習得や語学習得などにも展開可能だと考えている。

-

- 暦本 純一(東大/ソニーCSL),木村 直紀,河野 通就(東大), SottoVoce: 超音波画像と深層学習による無発声音声インタラクション, インタラクション2019

- Naoki Kimura, Michinari Kono, Jun Rekimoto. SottoVoce: An Ultrasound Imaging-Based Silent Speech Interaction Using Deep Neural Networks, ACM CHI 2019 [Honourable Mention Award] [Pre-print]